Data Lake: como armazenar e analisar informações sem limites

Índice:

- O que é data lake?

- Como funciona um data lake?

- Benefícios de um Data Lake

- Data Lake versus Data Warehouse

- Elementos essenciais de uma solução de Data Lake

- Plataformas de Data Lake

- Componentes da arquitetura de Data Lake

- Os 5 Vs do Big Data

- Maiores desafios de um Data Lake

- Implementação de equipamentos seguros

- Data Lake construído com storage NAS

- Aplicações práticas e dicas de proteção

- A importância de processos automatizados

- Diferentes camadas de segurança

- Invista em equipamentos de alto desempenho

A revolução tecnológica modificou a maneira de compreender informações em grande escala. Empresas buscam soluções cada vez mais eficientes para otimizar a análise de arquivos e promover decisões estratégicas.

A cada dia, profissionais identificam novas formas de tratar um volume crescente de dados corporativos, criando metodologias que integrem rapidez e confiabilidade.

Nesse cenário, surgem múltiplas discussões sobre como aprimorar a jornada dos gestores perante esses conteúdos digitais.

O universo da análise de informações desperta o interesse de diversas áreas, desde marketing até pesquisa científica.

Essa demanda reforça a necessidade de estruturas que agreguem eficiência, segurança e escalabilidade.

A consolidação dessa mentalidade, voltada para insights precisos, estimula o investimento em infraestruturas robustas, dispostas a acomodar desde arquivos semiestruturados até coleções massivas de conteúdo não estruturado.

O que é data lake?

Data lake é uma estrutura que armazena grandes volumes de informações em seu estado bruto, sem a necessidade de organização prévia, permitindo a análise posterior de diferentes formatos e origens de arquivos de maneira flexível e escalável, o que favorece a agilidade no uso de dados empresariais.

Essa abordagem surgiu como resposta às limitações de sistemas tradicionais, ao propor um repositório unificado para todo tipo de conteúdo digital, seja textual, de sensores ou multimídia.

A partir desse princípio, o data lake se destaca por reunir todo e qualquer tipo de conteúdo em um único lugar, dispensando a categorização imediata antes da inserção. Essa característica contrasta com métodos convencionais que exigem modelagem prévia.

Ao concentrar os arquivos em sua forma original, a análise pode ocorrer de acordo com as necessidades específicas de cada projeto, resultando em maior flexibilidade na extração de insights.

Nesse sentido, o data lake simplifica a integração de recursos avançados de aprendizado de máquina e inteligência artificial, pois possibilita o acesso a informações variadas sem imposições rígidas de estrutura.

Como funciona um data lake?

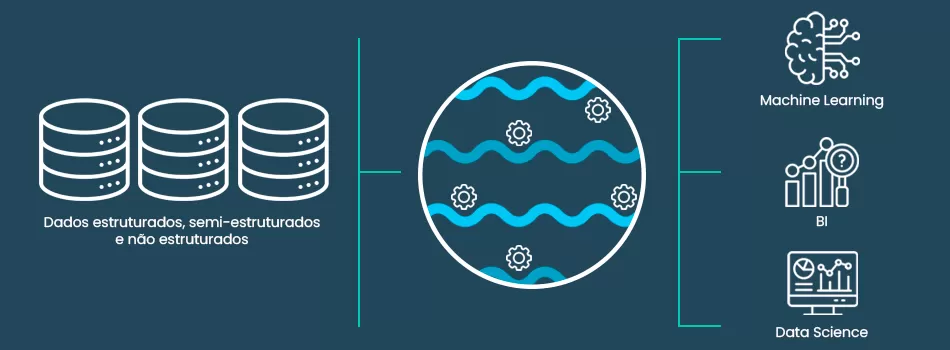

O funcionamento de um data lake envolve a ingestão de múltiplas fontes de arquivos em um ambiente centralizado, onde se preservam metadados e conteúdos originais.

Nesse cenário, diferentes ferramentas de indexação e catalogação trabalham para facilitar a recuperação de informações, permitindo que cientistas de dados e analistas identifiquem padrões em meio a registros semiestruturados ou completamente desorganizados.

Essa estrutura baseia-se na ideia de extrair valor posteriormente, pois armazena conteúdos variados em um repositório unificado.

Ao adotar esquemas de leitura tardia, a plataforma processa o formato dos arquivos apenas no momento da análise, o que amplia a flexibilidade das consultas.

Da mesma forma, essa metodologia se adapta de forma natural às demandas das empresas modernas, que precisam lidar com dados vindos de canais digitais, sensores de IoT e transações corporativas.

Benefícios de um Data Lake

A implementação de um data lake traz vantagens perceptíveis, especialmente no que diz respeito à adaptação a exigências dinâmicas do mercado.

Organizações que lidam com grandes volumes de informação encontram nessa abordagem uma forma de obter insights a partir de conteúdos não estruturados, o que favorece iniciativas de pesquisa e desenvolvimento.

Outro benefício consiste na redução de barreiras para inovação, pois o data lake facilita experimentos em grande escala.

Equipes de análise podem testar hipóteses, criar modelos preditivos e descartar abordagens que não geram resultados satisfatórios, tudo sem engessar os processos de ingestão.

Da mesma maneira, essa solução apresenta custos competitivos, já que utiliza métodos flexíveis de expansão de capacidade e prioriza a manutenção de formatos brutos em vez de transformações contínuas.

Data Lake versus Data Warehouse

Existe uma diferença significativa entre o data lake e o data warehouse. Enquanto o data lake enfatiza a inserção de conteúdos em estado bruto, o data warehouse depende de um modelo rigoroso de estruturação anterior ao carregamento.

No data warehouse, a informação passa por um processo de extração, transformação e carga, também conhecido pela sigla ETL, que organiza tudo com base em esquemas definidos.

O data lake oferece maior maleabilidade para projetos de análise, porém requer estratégias cuidadosas de governança para evitar que a plataforma se torne um depósito desorganizado.

Já o data warehouse favorece consultas rápidas sobre dados bem formatados e filtrados, mas não se mostra tão eficiente no armazenamento de arquivos não estruturados.

Vale refletir sobre o perfil da empresa antes de escolher o modelo mais adequado, pois a escolha incorreta pode desperdiçar recursos financeiros e técnicos.

Elementos essenciais de uma solução de Data Lake

Uma solução completa de data lake exige alguns elementos-chave para garantir seu pleno funcionamento.

Em primeiro lugar, a camada de ingestão cuida do recebimento de informações vindas de diversas fontes, desde sensores em tempo real até sistemas transacionais.

Nessa mesma lógica, o catálogo de metadados facilita a busca, já que identifica e descreve os conteúdos armazenados.

A governança também desempenha papel crucial, pois estabelece diretrizes de segurança e conformidade, definindo quem acessa o quê e qual é o nível de sensibilidade de cada arquivo.

Adicionalmente, um mecanismo de processamento escalável viabiliza a análise de grandes volumes, auxiliando na descoberta de padrões e correlações.

Essa orquestração de recursos técnicos fortalece o potencial do data lake para gerar resultados confiáveis e insights de alto valor para a tomada de decisões.

Plataformas de Data Lake

Diferentes plataformas de mercado oferecem suporte à criação e manutenção de data lakes, cada uma com suas particularidades e integrações.

Alguns provedores de nuvem disponibilizam soluções específicas que se integram a serviços de análise e machine learning, facilitando o consumo dos conteúdos por ferramentas especializadas.

Também existem plataformas autônomas que podem ser implementadas em ambientes on-premises, adequando-se às políticas de segurança e privacidade da organização.

Nesse sentido, a escolha de uma plataforma depende do perfil da empresa, do orçamento disponível e do nível de controle desejado sobre a infraestrutura.

Algumas companhias preferem soluções híbridas, pois combinam a flexibilidade da nuvem para análises específicas e a estabilidade de um ambiente local para arquivos críticos.

Seguindo tal lógica, manter um equilíbrio entre custo e desempenho costuma ser a chave para adotar a plataforma ideal de data lake.

Componentes da arquitetura de Data Lake

A arquitetura de um data lake envolve componentes que interagem para suportar todo o ciclo de vida dos arquivos.

Em primeiro lugar, há a camada de coleta, onde aplicações, sensores e sistemas corporativos enviam informações de forma bruta.

Depois, encontramos a camada de armazenamento, responsável por reunir esses conteúdos, preservando formatos originais e permitindo posterior classificação.

Conforme a empresa avança, surgem camadas de processamento que integram mecanismos de inteligência artificial, análise avançada ou relatórios, tudo alinhado aos requisitos de governança e segurança.

Por trás de todo esse cenário, a camada de metadados habilita a catalogação de cada item, facilitando buscas e mantendo controle sobre permissões de acesso.

Essa orquestração garante que as equipes possam explorar o data lake com eficiência e confiabilidade.

Os 5 Vs do Big Data

O crescimento exponencial de informações motivou a criação do conceito dos 5 Vs do Big Data: variedade, volume, velocidade, veracidade e valor.

- Variedade - reflete a multiplicidade de formatos existentes, indo de planilhas a vídeos de alta resolução.

- Volume - se relaciona à quantidade imensa de registros, cujo aumento exige tecnologias escaláveis para gerenciamento.

- Velocidade - aborda a rapidez com que a informação é produzida e consumida, pois algumas situações demandam análises em tempo real.

- Veracidade - lida com a qualidade e confiabilidade dos conteúdos, algo fundamental para relatórios confiáveis.

- Valor - diz respeito à capacidade de extrair insights relevantes, já que de nada adianta armazenar um mar de arquivos sem gerar utilidade efetiva para a empresa.

Maiores desafios de um Data Lake

Entre os principais obstáculos que envolvem um data lake, a governança e a segurança aparecem no topo da lista.

O risco de um repositório gigante sem organização ou controle de acesso pode acarretar exposição de informações sensíveis e geração de confusão sobre a procedência dos conteúdos.

Da mesma forma, a falta de estratégias de catalogação e indexação compromete a eficiência na hora de localizar e processar arquivos específicos.

Outro ponto crítico surge na necessidade de garantir qualidade e consistência ao longo do ciclo de vida dos materiais, pois dados redundantes ou sem integridade arruinam a confiabilidade das análises.

O último desafio compreende o armazenamento de informações do data lake em estruturas resistentes a falhas e escaláveis, evitando limitações que dificultam o crescimento das aplicações.

Essa barreira costuma demandar soluções robustas e planejamento a longo prazo, assegurando alta disponibilidade.

Implementação de equipamentos seguros

A configuração de um data lake não se limita à escolha de uma plataforma de software, pois o hardware exerce papel decisivo na eficiência.

Muitos especialistas aconselham a adoção de equipamentos confiáveis, principalmente quando se busca estabilidade e desempenho para cargas de trabalho intensas.

Nesse contexto, vale avaliar o uso de storage NAS, que fornece uma interface simplificada para compartilhamento de arquivos em rede.

Essa abordagem oferece escalabilidade e proteção dos conteúdos de forma clara, favorecendo a adoção de padrões de redundância.

Somente serviços de nuvem podem trazer fragilidades, pois o downtime associado à indisponibilidade da internet ou a eventuais falhas em data centers remotos pode ocasionar prejuízos consideráveis.

Em alguns cenários, a latência de acesso também se torna fator limitante, impactando análises que exigem respostas ágeis.

Investir em infraestrutura local ou híbrida com NAS se mostra vantajoso, pois reduz a dependência total de provedores externos e protege recursos críticos contra oscilações de conectividade.

Nesse sentido, a integração de uma solução de data lake com sistemas on-premises oferece controle mais preciso sobre políticas de segurança e conformidade regulatória.

Produtos sugeridos

Data Lake construído com storage NAS

Quem escolhe exclusivamente a nuvem pode enfrentar custos crescentes conforme o volume de arquivos aumenta, sem falar nas incertezas envolvendo mudanças de política das provedoras.

A possibilidade de perda de dados por erros de configuração ou até mesmo violações de segurança em serviços de terceiros preocupa líderes de TI, além de eventuais problemas de conectividade que dificultam o acesso em momentos críticos.

Uma arquitetura de data lake que aproveita servidores locais e equipados com sistemas de redundância oferece maior previsibilidade de desempenho e soberania sobre o tráfego interno.

Organizações que utilizam servidor NAS ganham maior eficiência operacional, pois conseguem organizar grandes volumes de conteúdos e aplicar mecanismos de controle sofisticados.

Esse método facilita tarefas de versionamento e simplifica a expansão de espaço em disco, sem deixar de lado recursos que impedem a fragmentação da estrutura.

Ao adotar um sistema local de alta capacidade para armazenamento de dados, a empresa previne interrupções que interrompem fluxos vitais.

Estratégias avançadas de replicação garantem que falhas em determinados componentes não impactem imediatamente toda a operação, o que preserva a continuidade do negócio.

Além disso, o data lake apoiado por storage local diminui o risco de variações abruptas no valor da conta mensal, pois não depende integralmente de serviços sob demanda.

Aplicações práticas e dicas de proteção

O data lake se aplica a diversas finalidades, como análise de comportamento do cliente, detecção de fraudes e pesquisas científicas.

Quando bem estruturado, ele suporta projetos de big data que alimentam algoritmos de aprendizado de máquina, modelando tendências de consumo e apontando caminhos para investimentos eficientes.

Entretanto, todo esse potencial precisa vir acompanhado de uma estratégia sólida de segurança.

Uma das iniciativas simples, porém cruciais, consiste em manter uma snapshot regular dos sistemas, pois ajuda a reverter qualquer alteração indevida em curto prazo.

Também se recomenda a configuração de RAID para criar redundância física, garantindo disponibilidade mesmo quando algum disco falha.

Estratégias de backup são indispensáveis, pois mantêm cópias adicionais dos conteúdos em diferentes locais, protegendo contra incidentes de alta gravidade.

Para complementar, a implementação de software de backup facilita a automatização de cópias recorrentes, reduzindo erros humanos e garantindo maior tranquilidade no dia a dia da equipe de TI.

Empresas que lidam com grande quantidade de aplicações e bancos de dados corporativos podem manter um backup de servidor específico, assegurando a recuperação rápida de sistemas críticos.

Nesse caminho, o uso de servidor de arquivos robusto coordena o compartilhamento e a organização das informações internas, ao passo que as análises em ambientes de machine learning são abastecidas de maneira fluida.

Quando a preocupação envolve histórico de documentos, o armazenamento de arquivos sistemático contribui para rastreabilidade e governança.

A importância de processos automatizados

Em um contexto de alta competitividade, confiar apenas em processos manuais resulta em riscos e falhas na preservação de conteúdos.

Por causa de requisitos de conformidade e auditoria, a automação dos procedimentos de proteção ganha relevância estratégica.

A adoção de backup automático otimiza a rotina de TI, pois minimiza a possibilidade de esquecimentos e falhas humanas, criando um esquema de proteção contínuo e confiável.

O mesmo raciocínio se aplica aos fluxos de ingestion, que podem ser executados em intervalos regulares a partir de múltiplas fontes de informação.

Nesse sentido, scripts e aplicações podem direcionar arquivos para o data lake sem intervenção humana, respeitando normas de segurança e registrando metadados de forma padronizada.

A vantagem é que as equipes técnicas liberam tempo para atividades de maior valor, como desenvolvimento de novos produtos ou análises estratégicas.

Diferentes camadas de segurança

Uma arquitetura segura envolve múltiplas camadas de proteção, incluindo criptografia em repouso e em trânsito, segmentação de redes e autenticação de vários fatores.

O objetivo se volta a impedir acessos indevidos e a reforçar a confiabilidade dos arquivos armazenados.

Esse modelo se mostra especialmente importante em setores como finanças e saúde, pois lida com informações altamente sensíveis.

A integração de soluções como NAS para backup oferece mais robustez ao data lake, já que se torna possível manter cópias em ambientes separados.

Esse cuidado impede que um único incidente comprometa todo o acervo digital, além de agilizar a recuperação em situações emergenciais.

Segundo especialistas, desenhar uma topologia resiliente depende de planejamento prévio e da adoção de tecnologias que atendam às necessidades do negócio sem sacrificar o desempenho.

Invista em equipamentos de alto desempenho

A consolidação de um data lake sólido e escalável requer planejamento cuidadoso e foco em eficiência.

A adoção de infraestrutura confiável, principalmente com sistemas de armazenamento robustos, representa um diferencial competitivo.

Vale lembrar a relevância de ferramentas e processos que assegurem proteção, alta disponibilidade e governança. A soma desses fatores previne incidentes que prejudicam a credibilidade das análises e impactam a lucratividade.

Empresas que buscam desempenho superior e proteção efetiva devem considerar a compra de um storage nas para modernizar sua estratégia de administração de arquivos e manter cópia de segurança.

Essa decisão tende a eliminar gargalos e ampliar a autonomia de TI, que pode realocar recursos em projetos mais inovadores em vez de conter problemas estruturais.

A robustez de um bom sistema de armazenamento local fornece a tranquilidade necessária para explorar todo o potencial de um data lake sem lidar com surpresas desagradáveis.

Fale hoje mesmo com um de nossos especialistas em armazenamento de dados da Data Storage.

Somos uma loja autorizada e especializada em soluções de armazenamento de dados, prontos para oferecer consultoria personalizada e apresentar a melhor tecnologia para atender às necessidades do seu negócio.

A segurança e a eficiência no armazenamento de grandes volumes de informações são fundamentais para qualquer empresa que almeja conquistar destaque no mercado.

Leia mais sobre: Armazenamento de dados

Tudo o que você precisa saber sobre soluções de armazenamento de dados e imagem digital.

SUPORTE

Técnicos Especializados

Nossa equipe é altamente qualificada para atender a sua necessidade.